George WoodmanResponsable du Quantum

23 juin 2021

L’informatique quantique vaut-elle vraiment le coup ?

9 minutes

L’informatique quantique (IQ) est sans doute, aujourd’hui, l’un des domaines de recherche les plus prometteurs. Toutefois, la nature même de cette technologie fascinante soulève quelques questions. Il est en effet difficile d’imaginer qu’elle puisse résoudre des problèmes concrets, car elle repose sur des mécanismes assez abstraits. Pourrait-on mettre à profit cette technologie pour en tirer un avantage concurrentiel – compte tenu, surtout, du volume de recherches que cela supposerait ? En d’autres mots, l’informatique quantique vaut-elle vraiment le coup ?

Certes, la théorie quantique est d’une grande complexité. Même s’il peut sembler presque impossible à un non-scientifique de comprendre l’informatique quantique, il n’est toutefois pas nécessaire d’avoir une formation dans ce domaine, ni même en informatique classique, pour percevoir les avancées qu’elle peut permettre. Pour toute une gamme spécifique de problèmes, un ordinateur quantique possède le potentiel pour fournir une accélération polynomiale ou, dans certains cas, exponentielle, aux problèmes de calcul qui peuvent se poser. En des termes accessibles aux néophytes, cela signifie que plus la taille du problème (le nombre d’entrées, par exemple) augmente, plus la vitesse d’exécution est élevée par rapport à un ordinateur classique. Grâce à l’IQ, un problème ne pouvant être résolu aujourd’hui qu’à très petite échelle pourrait donc, à l’avenir, se solutionner par un scénario réel.

Optimisation et simulations de Monte-Carlo.

Quels sont les problèmes qui pourraient être concernés par de telles solutions ? Trouver les facteurs premiers de grands nombres, par exemple. La décomposition en facteurs premiers est extrêmement utile pour les protocoles de sécurité sur Internet, ce qui fait de l’IQ une menace potentielle pour la cyber sécurité. La plupart des cas d’utilisation concrète se répartissent généralement au sein des catégories suivantes : problèmes de simulation en chimie, problèmes d’optimisation, problèmes de factorisation et applications d’algèbre linéaire pour le machine learning.

L’optimisation vise à déterminer la valeur maximale ou minimale d’une fonction mathématique. Il existe un nombre infini de manières d’établir cette fonction, ce qui permet de transposer plusieurs problèmes en un unique problème d’optimisation. L’exemple le plus courant est celui du représentant de commerce, qui doit se rendre dans différentes villes et cherche quel est le plus court chemin pour visiter chaque ville une seule fois. Appliqué au domaine de la finance, l’optimisation serait le moyen de créer une trajectoire de portefeuilles

dont l’ensemble des actifs pourrait minimiser les risques et maximiser le rendement espéré, tout en équilibrant la covariance entre ces deux variables.

Dans le domaine de l’assurance, les simulations de Monte-Carlo sont elles aussi très intéressantes, car elles font intervenir une fonction ayant une variable aléatoire, à partir de laquelle une simulation doit être réitérée des millions, voire des milliards de fois pour former une distribution. Ces simulations nécessitent généralement une énorme puissance de calcul classique pour arriver à fournir une solution précise.

Résoudre les problèmes de la vraie vie

De nombreux challenges pourraient, en théorie, tirer profit de la puissance de calcul issue de l’informatique quantique, en particulier dans le domaine financier. Par exemple, conformément aux accords de réglementation bancaire Bâle III, les institutions financières sont tenues d’effectuer des tests de résistance en utilisant la VaR (Value at Risk, littéralement valeur à risque

ou valeur en jeu

) pour déterminer le potentiel de pertes : un calcul qui pourrait être fait grâce aux simulations de Monte-Carlo, voire même être accéléré de façon quadratique[1] grâce à l’informatique quantique à tolérance aux pannes.

En termes de répartition des actifs, l’informatique quantique pourrait contribuer à maximiser les rendements et à minimiser les risques en optimisant les portefeuilles. Dans le domaine des catastrophes naturelles, elle pourrait accélérer prodigieusement la modélisation des phénomènes dangereux afin de mieux les prévoir, permettant ainsi aux assureurs d’utiliser ces informations pour fixer plus efficacement le prix des obligations. Des opérations comme la VaR ou le Portfolio Risk pourraient être améliorées en affinant la prédiction des risques potentiels. Hypothétiquement, l’informatique quantique pourrait aussi être appliquée de façon concrète à la modélisation et à la tarification imbriquées, avec la possibilité d’améliorer la précision des classificateurs binaires dans l’évaluation du crédit.

Les limites de l’informatique quantique

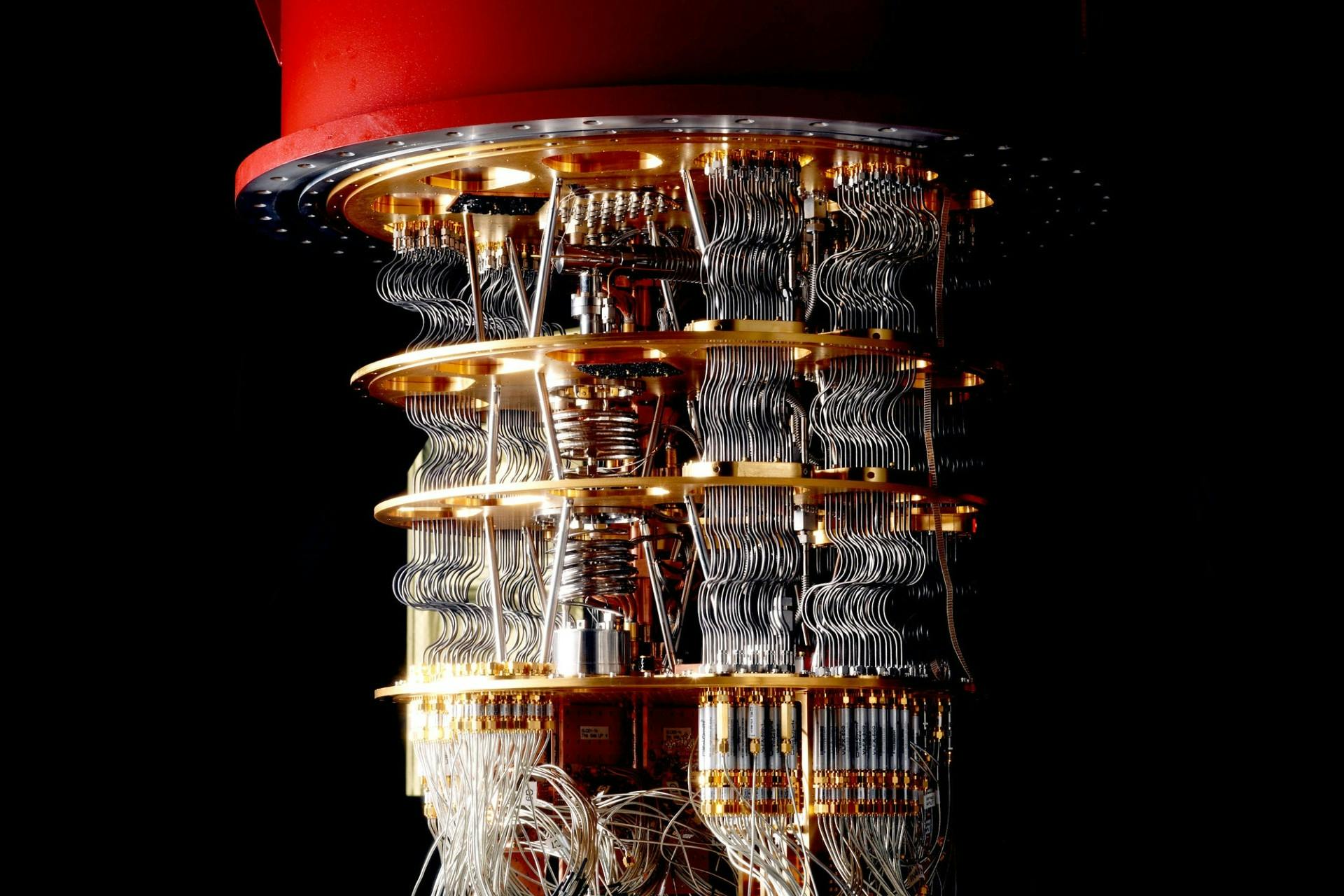

Même s’il est prometteur, le domaine de l’informatique quantique doit encore faire face à de nombreux défis. L’un des principaux problèmes auxquels sont confrontés les ordinateurs quantiques est celui de la quantité de puissance de calcul stable nécessaire à l’exécution de certains algorithmes. Une question qui ne sera pas réglée avant quelques années, en raison de l’immaturité relative de la technologie. Les limites de l’informatique quantique peuvent être répertoriées ainsi :

- Puissance de calcul : l’ordinateur quantique universel le plus puissant ne dispose aujourd’hui que de 65 qubits physiques. On estime qu’il en faudrait 1,6 million pour obtenir un avantage financier – pour la tarification des produits dérivés financiers utilisant la méthode de Monte-Carlo.[2]

- Bruit/chaleur : les états quantiques sont par nature instables ; toute interaction extérieure, la chaleur par exemple, peut les déstabiliser. La correction complète des erreurs pourrait être l’une des principales améliorations apportées à l’informatique quantique dans les années à venir.

- Temps de cohérence : en raison d’un grand nombre de facteurs, notamment le bruit, les états quantiques ne sont en bonne condition de calcul que pendant une minute, ce qui constitue une limite stricte à la quantité de puissance de calcul disponible.

- Etats d’intrication : une partie de la véritable puissance de l’informatique quantique vient du fait que les états peuvent être

intriqués

(ouenchevêtrés

). L’intrication cohérente de plusieurs états est toutefois difficile à réaliser et à conserver. - Mémoire : A l’heure actuelle, il est impossible de sauvegarder les états quantiques pour les charger ultérieurement. Un domaine de recherche se consacre particulièrement à la mémoire quantique (QRAM), afin de trouver un moyen de conserver des états quantiques en vue d’une utilisation ultérieure au sein de programmes quantiques.

Faut-il s’y mettre ?

Nous sommes entrés dans l’ère des technologies quantiques d’échelle intermédiaire bruitées (Noisy Intermediate-Scale Quantum, ou Nisq), mais il existe encore des applications potentielles qui pourraient se révéler très utiles à cette forme encore embryonnaire de technologie. Ces cas d’utilisation doivent couvrir des problèmes simples mais requérant un très haut niveau de précision, comme l’allocation d’actifs dans le cadre de la gestion des investissements, car leurs algorithmes quantiques potentiels ont été conçus pour accélérer les processus à court terme, que ce soit par le biais d’un recuit quantique (quantum annealer) ou d’un ordinateur quantique universel. Le processus suivi pour exécuter ces cas d’utilisation, aussi minimes soient-ils, se révélera d’une grande utilité dans l’avenir. La limite constituée par la taille du problème ne fera que s’atténuer avec le temps, à mesure que le matériel informatique se perfectionnera.

L’informatique quantique est un domaine complexe ; sa mise en œuvre dans un contexte de production exige énormément de travail. Mais, au fond, la réalité de l’informatique quantique se résume à prendre conscience que cette technologie n’est pas tant liée à la question du si

qu’à celle du quand

: s’y préparer doit dès lors devenir une priorité. Certes, l’informatique quantique exige de fournir un travail considérable sur une longue période de temps – mais un groupe financier qui veut se maintenir sur le long terme ne peut pas faire l’économie de cet effort. Savoir à quel moment concentrer cet effort, à quel endroit le mettre en œuvre et avec quelle ampleur sont des questions qui restent encore en débat.

Et demain ?

La question que l’on se pose le plus souvent au sujet de l’informatique quantique est la suivante : à quel moment cette technologie sera-t-elle au point ? La réponse courte, selon le calendrier actuel, est que l’application de la théorie quantique qui apporterait une réelle valeur commerciale dans le domaine de la production devrait apparaître au cours des 5 à 10 prochaines années. La réponse longue, elle, est plus complexe, comme pour tout autre sujet.

En réalité, tout dépend du problème pour lequel on souhaite avoir recours à l’informatique quantique. Par exemple, la résolution d’un problème d’optimisation ayant des variables binaires et des contraintes linéaires pourrait bénéficier de cette technologie d’ici les trois prochaines années, alors que pour d’autres problèmes il faudra attendre beaucoup plus longtemps.

Dans le même temps, les algorithmes classiques s’améliorent constamment, ce qui place toujours plus haut la barre à atteindre pour augmenter la vitesse de l’informatique quantique. Il ne fait cependant aucun doute qu’une fois démontré qu’une application d’IQ utilisable fonctionne plus rapidement qu’un ordinateur classique, ce n’est qu’une question de temps avant que nous assistions à la suprématie quantique

, étant donné le rythme de croissance exponentielle.

Dans quelques années, les machines hybrides combinant ordinateurs quantiques et ordinateurs classiques pourraient également façonner le futur visage de l’informatique. L’informatique quantique ne pouvant résoudre qu’une partie des problèmes, il y a fort à parier qu’elle deviendra probablement hybride.

3 questions à Iordanis Kerenidis

Head of Quantum Algorithms chez QC Ware Corp et Directeur de recherche au CNRS

Q: Pourquoi est-il pertinent de s’impliquer dès aujourd’hui dans l’informatique quantique ?

A: L’informatique quantique a le potentiel nécessaire pour révolutionner de nombreux domaines grâce à diverses applications, notamment dans la finance. Cela prendra du temps, car les outils ne sont pas encore assez puissants pour être utilisés au niveau industriel. Mais on ne peut pas se contenter d’attendre que ces outils soient au point. Pour être prêts au moment voulu, il faut commencer dès maintenant à comprendre comment les utiliser. Assimiler le fonctionnement des algorithmes quantiques et apprendre à développer des applications pour ces machines demande beaucoup de temps et de travail. C’est pourquoi il est essentiel de s’y atteler le plus tôt possible ; c’est un peu comme une police d’assurance. S’impliquer dès aujourd’hui est le meilleur moyen d’être prêt demain et de pouvoir intégrer ces outils dans nos méthodes de travail de façon rapide et fluide.

Q: Quels sont les principaux défis à relever pour implanter l’informatique quantique dans un groupe comme AXA ?

A: Ce qu’il faut à tout prix prendre en compte, c’est que la technologie d’informatique quantique est un procédé de calcul extrêmement différent des autres. Un ordinateur quantique n’est pas qu’un processeur plus rapide : pour en tirer le meilleur parti, il faut complètement changer le paradigme et le type d’algorithme que l’on exécute. Par conséquent, l’un des principaux défis des entreprises d’aujourd’hui consiste à acquérir du savoir-faire dans ce domaine et à se créer une propriété intellectuelle, en concevant et en brevetant de nouveaux algorithmes et de nouveaux modèles. Dans quelques années, les supports quantiques seront accessibles au plus grand nombre, comme le sont aujourd’hui les clusters GPU ; les entreprises disposant d’un avantage concurrentiel seront alors celles qui auront conçu et déposé ces nouveaux algorithmes et modèles.

Q: Quels sont les cas d’utilisation qui, selon vous, seront les premiers à générer de la valeur ?

A: Les simulations de Monte-Carlo, l’optimisation et les applications de machine learning sont les premiers cas qui me viennent à l’esprit. Pour chacun d’entre eux, il y a de fortes chances d’assister à des cas d’utilisation réelle dans les prochaines années. Les cas d’utilisation liés à l’optimisation, qui peut se révéler extrêmement utile et influente, pourraient être les premiers à se concrétiser, en raison notamment du grand nombre d’expertises déjà existantes sur la façon de résoudre ce genre de problèmes grâce à des ordinateurs quantiques. Le machine learning et les simulations de Monte-Carlo nécessitaient auparavant une puissance de calcul beaucoup plus importante, mais nous sommes récemment parvenus à réduire les ressources nécessaires, ce qui a permis de constater des cas d’utilisation concrète sur le court terme. Il faudra peut-être attendre encore quelques années, car les ensembles de data sont très volumineux, mais nous avançons plus rapidement que prévu.

La version française est une traduction de l’article original en anglais, à des fins informatives exclusivement. En cas de divergences, l’article original en anglais prévaudra.

Si vous avez des questions, vous pouvez contacter george.woodman@axa.com

1. S. Chakrabarti, R. Krishnakumar et al. A Threshold for Quantum Advantage. Par exemple, avec 7,5 000 qubits logiques, pour Monte-Carlo le niveau de précision exigé est assez élevé, ce qui nécessite une correction des erreurs. Actuellement, le maximum serait d'environ 1000:1, mais il est toutefois possible de prendre des libertés et 200:1 à cette échéance devrait suffire. 7,5K * 200 = 1,6M.

2. A. Montanaro. Quantum speedup of Monte Carlo methods. Proc. Roy. Soc. Ser. A, vol. 471 no. 2181, 20150301, 2015