Théo KotulaAnalyste ESG, AXA IM

26 septembre 2022

Intelligence artificielle : IA responsable et croissance à long terme

Notre approche de l’IA responsable repose sur une structure similaire et sur quatre piliers clairement définis : les systèmes d’IA utilisés par les entreprises doivent être équitables, éthiques et transparents, tout en restant soumis à la supervision humaine, tant du point de vue technique que de la gouvernance de haut niveau.

11 minutes

Contenu original : AXA IM

- L’adoption de plus en plus répandue de la technologie de l’IA et une meilleure compréhension de son potentiel commencent à soulever certaines questions dans l’esprit des investisseurs responsables concernant son utilisation par les entreprises.

- Si les systèmes d’IA offrent des possibilités évidentes, la réglementation devient plus contraignante pour mieux faire face aux risques ; les investisseurs doivent être vigilants vis-à-vis des atteintes à la réputation résultant de violations de la vie privée ou de failles de sécurité.

- Face au manque de sensibilisation à ces questions dans les entreprises, nous avons établi un cadre d’engagement pour favoriser une meilleure divulgation et un contrôle plus efficace.

L’intelligence artificielle (IA) a radicalement transformé le contexte commercial ; elle est devenue incontournable pour les entreprises d’un large éventail de secteurs, de la finance à la santé en passant par l’automobile.

Les systèmes d’IA ont beaucoup évolué depuis leur création : ils sont désormais capables de combiner des ensembles complexes de données avec l’informatique, en vue d’imiter les capacités humaines en termes de résolution de problèmes et de prise de décision. Les applications de l’IA dans le monde réel sont également très variées, allant de l’automatisation du service clients à l’optimisation des opérations de service ou des caractéristiques des produits.

Le recours à l’IA continue de se généraliser. Selon une étude de McKinsey1, sur plus de 1 800 entreprises interrogées, 56 % avaient adopté l’IA en 2021, contre 50 % en 2020. Cette enquête indique également que la proportion de répondants qui attribuent au moins 5 % de leur bénéfice avant intérêts et impôts (BAII) à l’IA est passé de 22 % en 2020 à 27 % l’année suivante.

Une étude similaire, menée par Gartner en 2022, a elle aussi mis en évidence les applications croissantes de l’IA dans les entreprises2, révélant que 40 % des structures interrogées ont déployé des milliers de modèles d’intelligence artificielle. Selon Gartner, la valeur commerciale de l’IA devrait atteindre 5,1 milliards de dollars d’ici 2025.

Pourtant, malgré cet essor, il est nécessaire d’instaurer des pratiques plus responsables en matière d’IA pour maintenir cette croissance et faire face aux répercussions éthiques et sociotechniques potentielles de l’intelligence artificielle.

En tant que gestionnaire mondial d’actifs investissant massivement dans le secteur technologique, nous pensons pouvoir jouer un rôle positif en encourageant l’IA responsable. Nos recherches visent donc à définir les principes qui sous-tendent cette technologie et à comprendre comment ils peuvent être mis en pratique sur le long terme.

Risques et opportunités de l’IA

Les systèmes d’IA constituent des opportunités potentielles de générer des rendements pour les clients, compte tenu de la valeur réelle que les entreprises peuvent en tirer. Ils sont notamment au fondement du métavers, dont ils permettent l’évolutivité et l’automatisation3 ; le deep learning et le traitement automatique de la langue naturelle (NLP) apportent des améliorations considérables aux activités et aux interactions dans le Web 3.04.

L’IA et le métavers pourraient, selon nous, être à l’origine d’opportunités d’investissement croissantes et tangibles, alimentées par les entreprises ayant le potentiel de générer une forte croissance annuelle au cours de la prochaine décennie.

D’un point de vue environnemental, social et de gouvernance (ESG)5, l’IA devrait permettre aux investisseurs de collecter et d’analyser des informations concernant les risques et les opportunités à une échelle encore sans précédent. Son potentiel est considérable, en particulier, dans l’utilisation des algorithmes d’analyse des sentiments et des solutions NLP permettant de mieux intégrer les principes ESG dans les stratégies d’investissement6.

Chez AXA IM, nous avons développé notre propre technique d’investissement à impact basée sur le NLP, qui note certaines parties de documents d’entreprise pour aider à évaluer dans quelle mesure ces dernières peuvent soutenir les objectifs de développement durable (ODD) des Nations unies.

Par ailleurs, une autre étude a démontré que l’IA pouvait apporter une nette contribution à la réalisation des 169 objectifs plus détaillés des 17 grands ODD 7. Citons par exemple une technologie permettant de mieux identifier les matériaux recyclables afin de réduire les quantités de plastique dans les océans, ou encore une plateforme utilisant les données satellitaires et l’IA pour limiter le gaspillage de l’eau.

Toutefois, parallèlement aux opportunités et aux applications potentielles qu’ils peuvent offrir, les systèmes d’IA comportent également des risques non négligeables, dont les plus visibles sont la violation de la vie privée et les atteintes à la cybersécurité, qui peuvent rapidement nuire à la réputation d’une entreprise.

L’IA génère également des risques sociétaux et des risques liés aux droits de l’homme qui, bien que plus difficiles à définir et à mesurer, sont sans doute les plus graves.8. Plus particulièrement, les systèmes d’IA peuvent être à la source de nombreuses discriminations : utilisée dans les services financiers, la network discrimination

(discrimination en réseau) peut servir à empêcher certaines communautés d’obtenir des prêts bancaires ; dans le domaine du recrutement, l’IA peut reproduire des modèles existants de préjugés sociaux.

Même lorsqu’elle est utilisée pour modérer des contenus, le procédé du marquage automatique porte parfois atteinte au droit à la liberté d’expression et d’opinion, sans parler des problèmes juridiques et éthiques soulevés par la capacité d’identifier et de suivre des individus grâce à l’IA.

Réglementation : un cadre en gestation

Les risques non négligeables liés à l’adoption de l’IA sont en train de donner naissance à un nouveau paysage réglementaire. Dans ce domaine, l’Union européenne est en pleine élaboration d’une réglementation qui fait écho au Règlement général sur la protection des données (RGPD)9 et dont l’objectif est de faire face aux risques associés à certaines utilisations spécifiques de l’IA, tout en renforçant la confiance dans les systèmes utilisés10.

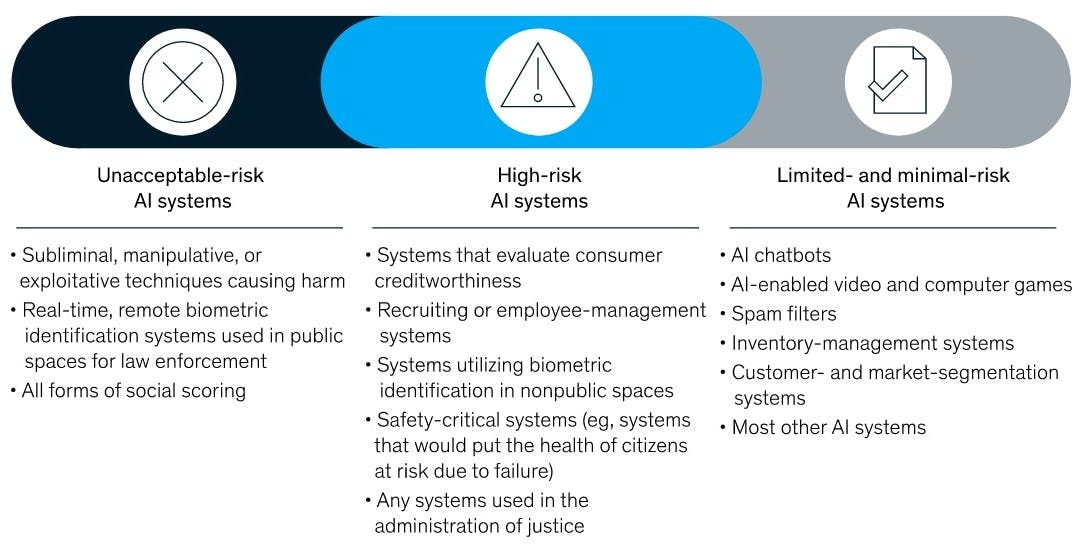

Classification européenne des risques liés aux systèmes d’IA

McKinsey & Co. What the draft European Union AI regulations mean for business, 2021: Relevance of AI risks for companies

Ce projet de réglementation va interdire l’utilisation des systèmes à risque inacceptable au sein de l’UE. Les systèmes à risque élevé seront, eux, soumis à diverses exigences, notamment en matière de surveillance, de transparence, de cybersécurité, de gestion des risques, de qualité des données, de suivi et de déclaration obligatoire. Cette réglementation exigera la transparence dans l’utilisation des systèmes à risque limité ou minimal, afin que les utilisateurs soient prévenus qu’ils interagissent avec des technologies d’IA.

Ces normes européennes ne seront pas seulement destinées aux entreprises et aux fournisseurs d’IA au sein de l’espace européen : leur compétence s’étendra au niveau extraterritorial sur tout système d’IA ayant des répercussions dans l’Union européenne. Les entreprises en infraction avec cette réglementation pourraient en outre écoper de pénalités allant jusqu’à 30 millions d’euros ou 6 % de leur chiffre d’affaires mondial – en se basant sur le chiffre le plus élevé -, soit des amendes plus lourdes encore que celles prévues par le RGPD.

Alors que la gestion et la réglementation de l’IA sont de plus en plus prises en compte par les gouvernements et les organismes de régulation du monde entier, les risques pourraient, selon nous, s’intensifier pour les entreprises d’un point de vue juridique et financier.

Des approches plus responsables de l’IA

Au-delà de l’aspect réglementaire, la Commission européenne a établi des Lignes directrices en matière d’éthique pour une IA digne de confiance11 pouvant servir de cadre aux entreprises pour mettre en œuvre des pratiques d’IA plus responsables. Le but de ces principes est d’encourager une IA légale, éthique et capable de résister aux dommages potentiels qu’elle pourrait engendrer.

Ces lignes directrices s'articulent autour de quatre principes éthiques qui imposent aux entreprises des contraintes concrètes :

- Respect de l’autonomie humaine : Garantir le respect de la liberté et de l’autonomie des êtres humains. La répartition des tâches entre êtres humains et systèmes d’IA devrait suivre des principes de conception centrés sur l’humain et donner à l’humain une possibilité réelle de poser des choix. Il convient de veiller à la supervision et au contrôle humains sur les processus de travail des systèmes d’IA.

- Prévention de toute atteinte : Les systèmes d’IA ne devraient ni porter atteinte, ni aggraver toute atteinte portée, ni nuire aux êtres humains d’une quelconque autre manière. Il convient également d’accorder une attention particulière aux situations dans lesquelles les systèmes d’IA peuvent entraîner ou aggraver des incidences négatives du fait d’asymétrie de pouvoir ou d’information. Cela englobe la protection de la dignité humaine ainsi que de l’intégrité mentale et physique.

- Equité : Garantir une répartition égale et juste des bénéfices et des coûts, et veiller à ce que les individus et les groupes ne fassent pas l’objet de biais injustes, de discrimination et de stigmatisation. L’utilisation de systèmes d’IA ne devrait jamais avoir pour conséquence de tromper les utilisateurs (finaux) ou de limiter leur liberté de choix. Le volet procédural de l’équité suppose la capacité de contester les décisions prises par les systèmes d’IA et par les êtres humains qui les utilisent.

- Explicabilité : Les processus doivent être transparents, les capacités et la finalité des systèmes d’IA doivent être communiquées ouvertement et les décisions – dans la mesure du possible – doivent pouvoir être expliquées aux personnes directement ou indirectement concernées. Les algorithmes à effet

boîte noire

sont à éviter.

Chez AXA IM, notre approche de l’IA responsable repose sur une structure similaire et sur quatre piliers clairement définis : les systèmes d’IA utilisés par les entreprises doivent être équitables, éthiques et transparents, tout en restant soumis à la supervision humaine, tant du point de vue technique que de la gouvernance de haut niveau.

Nous sommes convaincus que les entreprises seront capables d’atténuer les risques liés à l’IA et de créer de la valeur durable si elles appliquent des pratiques d’IA responsables. L’objectif doit être de tirer profit du déploiement des systèmes d’IA tout en renforçant la confiance et la fidélisation des clients.

Pour résumer, adopter une approche responsable de l’IA ne consiste pas seulement à éviter les risques, mais également à s’assurer que ces technologies peuvent être exploitées au bénéfice des individus et des entreprises

Evaluer les pratiques responsables en matière d’IA

Nous nous sommes penchés sur une série d’études et d’outils de comparaison et d’évaluation qui s’intéressent aux approches et pratiques responsables des entreprises en matière d’IA ; des documents qui révèlent, en fin de compte, de grandes disparités dans les progrès réalisés.

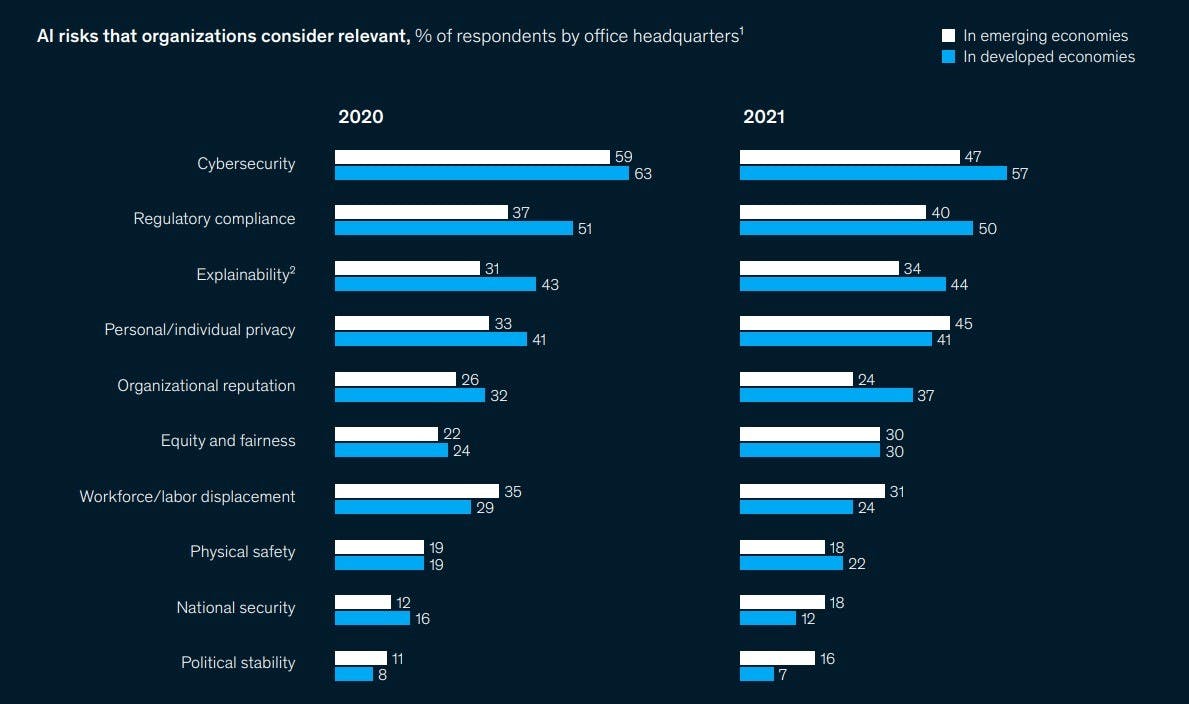

L’enquête McKinsey de 202112 met par exemple en évidence le un manque de sensibilisation des structures consultées aux différents risques liés à l’IA. Le graphique ci-dessous illustre à quel point les entreprises tendent à sous-estimer ce genre de risques.

Evaluation par les entreprises des risques liés à l’IA

McKinsey & Co. The state of AI in 2021, 2021: Relevance of AI risks for companies

De même, le Big Tech Scorecard 2022 établi par Ranking Digital Rights (RDR)13 14, un programme de recherche indépendant, a classé les entreprises technologiques relativement défaillantes en termes de transparence algorithmique, sur la base d’indicateurs similaires à ceux que nous venons d’évoquer, notamment les critères relatifs au respect des droits de l’homme dans le développement des algorithmes, à l’évaluation des risques, à la transparence et au respect de la vie privée.

Aucune des grandes entreprises technologiques évaluées n’a obtenu un score supérieur à 22 %, selon le classement de RDR, et certaines des plus importantes structures mondiales se situent même tout en bas du podium.

Le Digital Inclusion Benchmark établi par la World Benchmarking Alliance15 classe, quant à lui, les entreprises en fonction de la recherche et du développement inclusifs et éthiques

et cherche à évaluer à quel point les pratiques de l’entreprise reflètent la participation de divers groupes et la prise en compte de l’éthique dans le développement des produits

. L’examen des scores de référence pour une série d’entreprises révèle des performances décevantes, avec seulement 3 % des 77 entreprises étudiées qui ont obtenu les meilleures notations

Ces résultats contribuent, selon nous, à démontrer à quel point il est nécessaire pour les investisseurs responsables, tels qu’AXA IM, d’ouvrir la discussion sur une IA responsable au sein des entreprises et de dégager des lignes claires de mise en pratique. Dans le cadre de notre programme de recherche et d’engagement en matière de technologie responsable, nous nous concentrons plus particulièrement sur les entreprises dont les plans d’investissement sont significativement tournés vers le développement de l’IA.

Nos principales recommandations incitent notamment les entreprises à :

- S’aligner sur les principes clés de l’approche d’AXA IM en matière d’IA responsable (équité, éthique, transparence, surveillance humaine) ;

- Améliorer la divulgation et la transparence autour du développement des systèmes d’IA ;

- Garantir la supervision de l’IA responsable par le conseil d’administration et les cadres supérieurs.

L’atténuation des risques associés aux systèmes d’IA et la prise en compte des considérations réglementaires sont selon nous étroitement liées à la capacité des entreprises à assurer une création de valeur à long terme grâce à ces technologies. C’est lorsqu’une IA véritablement responsable est mise en pratique qu’elle peut fournir les opportunités les plus durables.

Sources:

[1] Global survey: The state of AI in 2021 - McKinsey, 2021

[2] The Gartner AI Survey Top 4 Findings - Gartner, 2022

[3] The Metaverse: Driven By AI, Along With The Old Fashioned Kind Of Intelligence - Forbes, 2022

[4] Web 3.0 is an evolving idea for the third generation of the internet, incorporating concepts of decentralisation and new blockchain technologies to improve web applications. Web 1.0 refers to the early period of the internet to about 2004 while Web 2.0 reflects the move into more user-generated content through centralised hubs.

[5] How can AI help ESG investing? - S&P Global, 2020

[6] Natural language processing (NLP) is a branch of computer science and AI that allows machines to process large volumes of written documents and rapidly analyse, extract, and use the content. Common uses include auto-correct technology and real-time sentiment analysis.

[7] The role of artificial intelligence in achieving the Sustainable Development Goals - Nature Communications, 2020

[8] Artificial Intelligence & Human Rights: Opportunities & Risks - Berkman Klein Center, 2018

[9] The EU's General Data Protection Regulation (GDPR) is a set of rules on data protection and privacy introduced in 2018 which is aimed at increasing an individual's control over their personal information.

[10] What the draft European Union AI regulations mean for business - McKinsey, 2021

[11] Ethics guidelines for trustworthy AI - European Commission Report, 2019

[12] Global survey: The state of AI in 2021 - McKinsey, 2021

[13] The 2022 RDR Big Tech Scorecard - Ranking Digital Rights, 2022

[14] Who We Are - Ranking Digital Rights

[15] Digital Inclusion Benchmark - World Benchmarking Alliance, 2021

La version française est une traduction de l’article original en anglais, à des fins informatives exclusivement. En cas de divergences, l’article original en anglais prévaudra.

Disclaimer

References to companies are for illustrative purposes only and should not be viewed as investment recommendations.

This document is for informational purposes only and does not constitute investment research or financial analysis relating to transactions in financial instruments as per MIF Directive (2014/65/EU), nor does it constitute on the part of AXA Investment Managers or its affiliated companies an offer to buy or sell any investments, products or services, and should not be considered as solicitation or investment, legal or tax advice, a recommendation for an investment strategy or a personalized recommendation to buy or sell securities.

Due to its simplification, this document is partial and opinions, estimates and forecasts herein are subjective and subject to change without notice. There is no guarantee forecasts made will come to pass. Data, figures, declarations, analysis, predictions and other information in this document is provided based on our state of knowledge at the time of creation of this document. Whilst every care is taken, no representation or warranty (including liability towards third parties), express or implied, is made as to the accuracy, reliability or completeness of the information contained herein. Reliance upon information in this material is at the sole discretion of the recipient. This material does not contain sufficient information to support an investment decision.

Issued in the UK by AXA Investment Managers UK Limited, which is authorised and regulated by the Financial Conduct Authority in the UK. Registered in England and Wales No: 01431068. Registered Office: 22 Bishopsgate London EC2N 4BQ

In other jurisdictions, this document is issued by AXA Investment Managers SA’s affiliates in those countries.